大家好,大模型 fine-tune,在各个领域百花齐放。

上两天发过一篇文章,介绍了一个基于 LLaMA 训练得到的 AI 医生咨询助手。

看不少小伙伴都感兴趣,咱今天再介绍一个法律领域的 LaWGPT。

LaWGPT

昨天,都在传,杭州互联网大厂裁员,消息铺天盖地,搞得人心惶惶。

合法裁员,给个 N+3 赔偿,那都还挺舒服。碰到非法裁员的,那咱就得拿起法律武器刚到底了。

比如问一问 LaWGPT,非法裁员咋么办?或者加班工资都怎么算?

输入:请问加班工资怎么算?

输入: 你能否写一段抢劫罪罪名的案情描述?

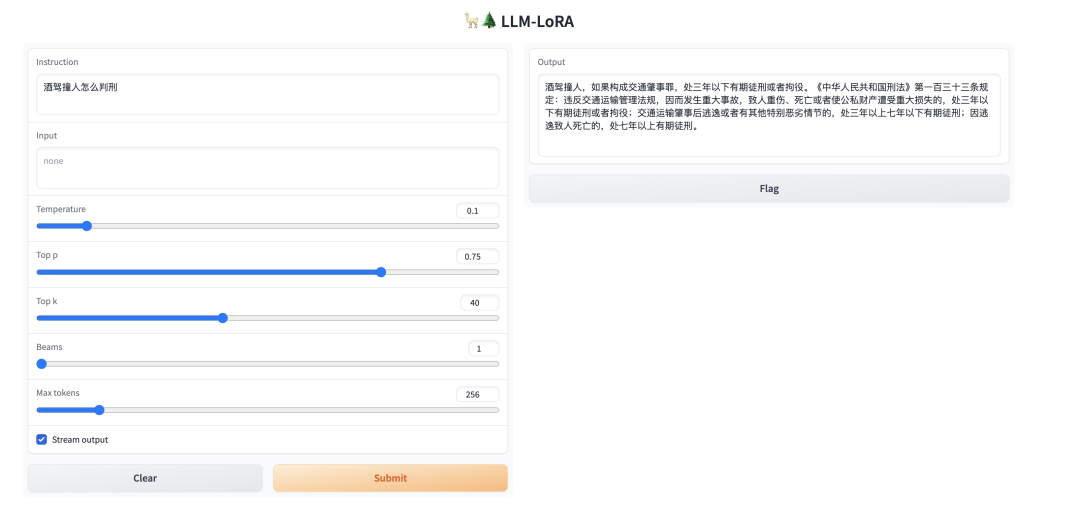

输入: 酒驾撞人怎么判刑?

效果还是可以的吧?

LaWGPT 的名字起得有些奇怪,因为看名字,第一眼以为是基于 GPT 训练的模型,结果一看内容发现是 LLaMA 训练的。

不过这都不重要,效果还是可以的。

项目地址:

https://github.com/pengxiao-song/LaWGPT

技术交流

技术要学会分享、交流,不建议闭门造车。一个人可以走的很快、一堆人可以走的更远。

好的文章离不开粉丝的分享、推荐,资料干货、资料分享、数据、技术交流提升,均可加交流群获取,群友已超过2000人,添加时最好的备注方式为:来源+兴趣方向,方便找到志同道合的朋友。

方式①、添加微信号:mlc2060,备注:来自CSDN + 加群

方式②、微信搜索公众号:机器学习社区,后台回复:加群

接下来,说下怎么运行算法。

不过这都不重要,我们先看下效果:

首先,创建虚拟环境,安装依赖。

git clone git@github.com:pengxiao-song/LaWGPT.git cd LaWGPT conda create -n lawgpt python=3.10 -y conda activate lawgpt pip install -r requirements.txt 其次,下载模型权重,这个项目获取权重的方法,需要自己合并模型,合并方法:

下载 chinese-llama-7b-merged 模型权重:

https://huggingface.co/minlik/chinese-llama-7b-merged/tree/main 下载 legal-lora-7b 模型权重:

https://huggingface.co/entity303/legal-lora-7b/tree/main 前者放到项目的 models/base_models 目录下,后者放到项目的 models/lora_weights 目录下。

然后运行权重合并脚本:

sh scripts/merge.sh 最后,我们就可以直接启动 UI 了:

bash scripts/webui.sh 浏览器打开本地服务:

http://127.0.0.1:7860

就能看到 UI 界面了。

整个项目的目录结构,还是挺清晰的。

LaWGPT ├── assets ├── resources ├── models │ ├── base_models │ └── lora_weights ├── outputs ├── data ├── scripts │ ├── finetune.sh │ └── webui.sh ├── templates ├── tools ├── utils ├── train_clm.py ├── finetune.py ├── webui.py ├── README.md └── requirements.txt 可以看到,项目也提供了 finetune 的代码,也能自己训练。

指令微调模型训练的方法,后面计划再出一期视频讲解了。

总之,也衷心希望接下来类似的裁员事件能少点,打工仔们不容易啊!碰到非法裁员,记得要用法律武器保护好自己的合法权益!

好了,今天就聊这么多吧,我们下期见!

原文链接:https://blog.csdn.net/2301_78285120/article/details/130876732?ops_request_misc=%257B%2522request%255Fid%2522%253A%2522170018760216800184155654%2522%252C%2522scm%2522%253A%252220140713.130102334.pc%255Fblog.%2522%257D&request_id=170018760216800184155654&biz_id=0&utm_medium=distribute.pc_search_result.none-task-blog-2~blog~first_rank_ecpm_v1~times_rank-7-130876732-null-null.nonecase&utm_term=AI%E6%B3%95%E5%BE%8B%E5%92%A8%E8%AF%A2