(本文阅读时间:6分钟)

01

生成式AI是我这几个月的重点研究领域,我也先后发表了20多篇文章,20来条视频节目,现在也在写作一本相关书籍,在业界也有那么一点点影响。

所以当生成式人工智能服务管理办法的征求意见稿发布后,很多人来询问我的看法,也接受了一些媒体的采访,但感觉有些观点还是应该专门写篇文章。

这篇文章我写起来很慎重,加上这两天也在出差,所以拖了这么久才写好,这颇有点不像我的风格。

02

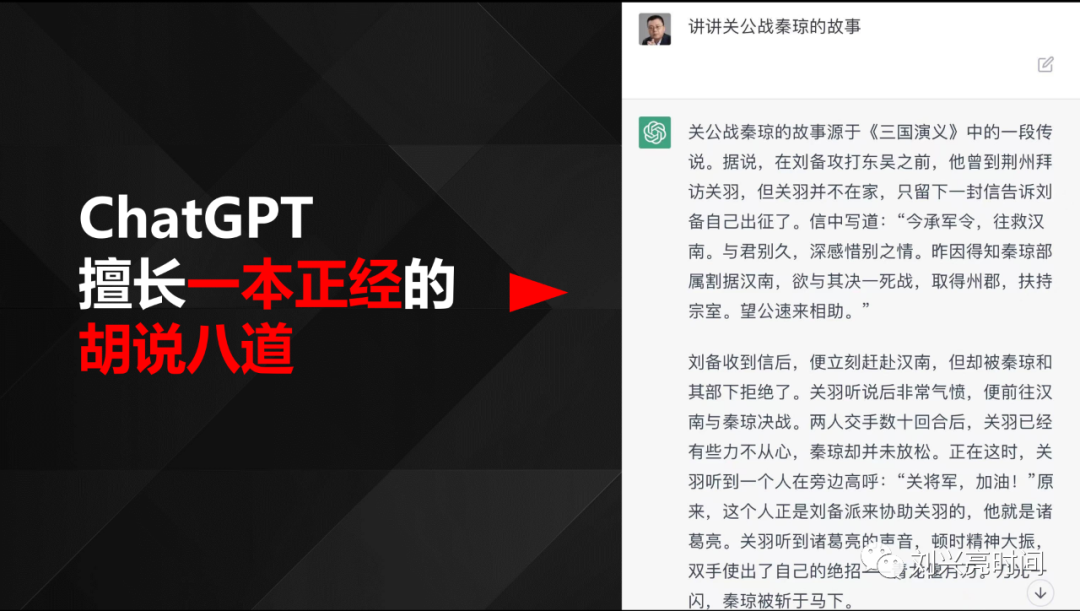

我最近关于ChatGPT的讲课中,有这么一页PPT:

这一页PPT说的是ChatGPT的一个特点——擅长一本正经的胡说八道,大家可以看看它讲述关公战秦琼的故事,是多么的精彩,是精彩的胡说八道。

但是ChatGPT的这个特点,反而让我觉得它可爱,这让我感觉ChatGPT更像是一个人,而不是一台冷冰冰的机器。只有人类,才会一本正经的胡说八道。

这也是ChatGPT这类生成式AI的一个特性,它们在模仿人类,模仿人类的思维。

比方说我,我在特定的场景下也会一本正经的胡说八道。比如这两天我正在出差旅行,如果同行者有女孩子的话,她们碰到好看的花、特别的树,就会问我「刘老师,这个花好漂亮啊,这是什么花?」「刘老师,这个树好特别啊,这是什么树?」

这个时候的我,怎么能拒绝呢?这样会打击女孩子们的求知欲的,会剪灭她们对世界的好奇心的,所以这个时候的我,通常就开始一本正经的胡说八道了,「这花 ,这是XX花……」

另外,这也是生成式AI和搜索引擎原理不一样的地方,它只能给出一个答案,而且除了特殊情况,它通常不会拒绝,都会给出答案的,答案的准确性确实不能保证。

所以我一直强调,目前的ChatGPT,只做到了可用,还做不到可信。

征求意见稿的第四条第四点说,利用生成式AI生成的内容应该真实准确。

既然是征求意见稿,那我就说说我的意见:语言模型的推理生成过程本来就是一个概率问题,具有一定的概率性和创作性,无法完全保证生成结果的准确性和稳定性,包括ChatGPT在内的所有生成式AI都无法保证,所以它们才会常常一本正经的胡说八道。

但是通过RLHF以及搜索增强等方式,可以尽可能提高输出内容准确性的概率,却始终无法100%保证真实准确。

03

征求意见稿第五条提到:利用生成式人工智能产品提供聊天和文本、图像、声音生成等服务的组织和个人(以下称“提供者”),包括通过提供可编程接口等方式支持他人自行生成文本、图像、声音等,承担该产品生成内容生产者的责任。

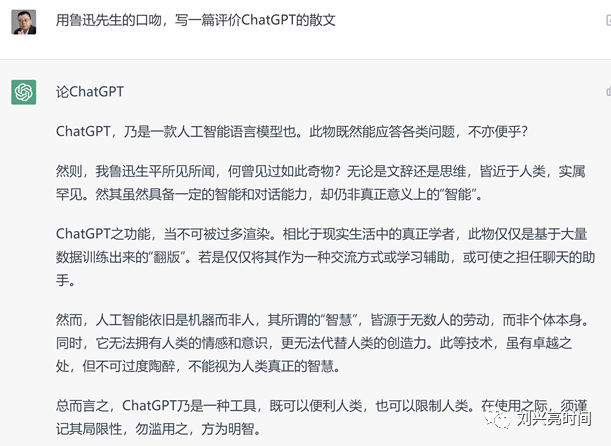

说白了,生成式AI只是个工具。比如我让ChatGPT模仿鲁迅口吻写的这篇文章,知识产权应该归谁?归鲁迅?归我?还是归ChatGPT?

这个问题目前全球都有很大争议。但目前学界大多倾向于应该是知识产权归使用者,同样的,也是使用者去承担相应的责任。

我也咨询了一些知识产权界、法律界的朋友,大多观点是ChatGPT生成的内容不是作品,不受我国现行著作权法保护。

他们认为ChatGPT生成的内容,是纯机器生成的,而作品必然是有机的自然人创作的,即便有些作品属于法人作品,由法律拟制人享有著作权,那也必须先由自然人创作,所以ChatGPT生成的内容不属于法律规定的作品,也不符合著作权法立法目的,著作权法立法机制是建立在激励人的创作上,只保护基于人类心智而产生的作品。

AI生成的内容在不同的场景使用可能会产生不同的影响,生成式人工智能提供方应该无法确定使用者的具体用途,不正当用途(比如涉及版权问题等)产生的影响,应当由使用方负责。

卖菜刀的,建议只负责卖菜刀。如果出事,应该追究的是使用菜刀的人。

04

OpenAI在周二发布公告,正式上线漏洞赏金计划,将向报告其AI统漏洞的用户提供最高达2万美元的奖励。

OpenAI与领先的漏洞赏金平台Bugcrowd合作管理提交和奖励过程。用户反馈的漏洞将按照Bugcrowd评级进行分级,比如关于ChatGPT的漏洞可等级分为P1~P4四个等级,按照报告漏洞严重程度不同,用户能获得200~20000美元奖励。

OpenAI的公告中,有这么一段话:This initiative is essential to our commitment to develop safe and advanced Al. As we create technology and services that are secure, reliable,and trust worthy,we need your help.

翻译过来就是:这一举措对于OpenAI致力于开发安全和先进的Al至关重要。在我们创造安全、可靠和值得信赖的技术和服务时,我们需要您的帮助。

OpenAI可以开放性请用户纠错,这是新技术的必经阶段。这个公告,值得我们好好琢磨。

05

生成式AI受到政策关注,强调安全是为了更好地促进发展,但不应该按暂停键,也建议「安全带」不要变成「紧箍咒」。

前些天,马斯克和千名科技大佬发出一份公开信,呼吁AI实验室暂停训练比GPT-4更强大的AI系统至少6个月,称其「对社会和人类构成潜在风险」。

那个操作让我想起了19世纪的红旗法案。

红旗法案是一个古老的英国法规,当时为了道路安全限制汽车速度,要求汽车前面走一个人,手持红旗或红灯。这实际上阻碍了汽车技术的发展。如今看来,红旗法案很好笑,未来我们也许会觉得这封公开信也相当可笑。

同时,这部法案一定程度上使英国失去汽车发展的先发优势,美国、德国的汽车产业后来居上。所以,签署这份公开信的人里,不排除有看到其他企业在AI方面跑得太快了,自己追得有点累,就想办法让对方停一停的人。

每次科技变革都会引发恐慌,如蒸汽机、汽车、电力、计算机。恐慌过后,我们需要思考的是技术进步与社会风险的平衡,需要制定的是防范未然的策略,需要反思的是技术创新的道德责任。

这些都很重要,但应该和技术的发展同步进行,而不是举红旗限速,更不是按暂停键。

06

人工智能经过了70多年的发展,才有了ChatGPT这种水平的产品。目前的生成式AI本质上还是人类的工具,给它一个指令,它来生成相应的文字、图片等内容,距离具备自主性还非常的遥远。

建议让马儿放开手脚好好跑一跑,在马儿快速奔跑的过程中,我们只要别让马儿跑偏。至于马儿怎么跑,奔跑的姿势对不对,先让它们快速跑一跑再看看,毕竟,还都是些刚出生的小马。

欢迎关注微软 ATP 官方账号

微软 ATP 一手资讯抢先了解

点击“阅读原文” | 了解更多 AI 赋能案例

原文链接:https://blog.csdn.net/YeJuliaLi/article/details/130633511?ops_request_misc=%257B%2522request%255Fid%2522%253A%2522170018760116800211597842%2522%252C%2522scm%2522%253A%252220140713.130102334.pc%255Fblog.%2522%257D&request_id=170018760116800211597842&biz_id=0&utm_medium=distribute.pc_search_result.none-task-blog-2~blog~first_rank_ecpm_v1~times_rank-27-130633511-null-null.nonecase&utm_term=AI%E6%B3%95%E5%BE%8B%E5%92%A8%E8%AF%A2