整理 | 朱珂欣

出品 | CSDN程序人生(ID:coder_life)

破防了,接到“女儿”的求救电话,竟不能相信自己的耳朵!

今年年初,美国亚利桑那州的 Jennifer DeStefano 就遇到了“耳听为虚”的骗局。

据《纽约邮报》报道,这通来自“女儿”的电话,实则是一起利用 AI 声音克隆技术的勒索案。

AI 仿声敲诈,需要 100 万赎金

那天下午,Jennifer DeStefano 收到了一个陌生电话号码的来电。

原本没在意,但想起 15 岁的女儿正在外地滑雪,出于担心就选择了接听。

谁料,听到电话那头传来了女儿的哭喊声:“妈妈!救我!”

紧接着,一位陌生男子开始发话:“你女儿在我这里,如果打电话报警或通知任何人,就把你女儿带到墨西哥去‘注射毒品’和‘强奸’。”

恐慌之中, Jennifer DeStefano 还听到电话那头女儿的呼救,声音非常真实。

男子还马上谈起了条件 —— 需要 100 万美元的赎金才能放人。但得知无法支付那么多赎金后,男子又改口称:“拿 5 万美元来换你的女儿。”

在顿感事情蹊跷之后, Jennifer DeStefano 选择了迅速联系丈夫,直到确认女儿正在安全地滑雪中,才幸免被骗。

事后回忆起通话细节时, Jennifer DeStefano 表示仍感到后怕,虽然如今明确这是电话诈骗,但想到“女儿的声音”如此逼真,让她细思极恐。

3秒即可克隆,多起诈骗案发生

经过多方证实,这是一起利用 AI 声音克隆技术进行的诈骗案。

针对这类基于 AI 的诈骗案,加州大学伯克利分校计算机科学教授、伯克利人工智能实验室成员 Hany Farid 对 AI 克隆语音的生成原理,做出了详细解释。

-

AI 语音生成软件,可以分析什么让人的声音与众不同(包括年龄、性别和口音),并搜索庞大的声音数据库以找到相似的声音,然后重新创造出相似整体效果的声音。

-

它通常从 YouTube、播客、商业广告、TikTok、Instagram 或 Facebook 等地方获取音频样本。

此外,亚利桑那州立大学人工智能专业计算机科学教授 Subbarao Kambhampati 还认为,AI 语音克隆技术正在迅速改进:“以前,克隆声音需要从被克隆人身上获取大量样本。现在,只需三秒钟就可以克隆出一个接近你的声音。”

该观点也得到了 Hany Farid 的“证言”:“一个好的克隆可以用不到一分钟的音频创建,甚至几秒钟就足够了。在 AI 软件的帮助下,语音克隆只需每月 5 美元,任何人都可以使用。”

然而,由于目前这类技术几乎没有受到监督,类似的“诈骗案”也不胜枚举。

3 月,据《纽约邮报》报道,居住在匹兹堡的 Beth Royce 接到了“姐姐”的求救电话后,给“绑匪”寄了 1000 美元赎金。事后, Beth Royce 表示:“很难描述电话中‘姐姐’的声音多么真实。”

甚至,以往被认为安全的“声纹”系统也存在明显漏洞。

4 月 20 日,国内郭先生收到了利用 AI 技术换脸和换声后伪装熟人的诈骗,“好友”称自己在外投标需要高昂的保证金,请求郭先生过户 430 万元。

3 月,《卫报》澳大利亚版记者 Nick Evershed 表示,他使用人工智能做出自己的声音,进入了他的 Centrelink 自助服务账户。在《卫报》调查后发现,Centrelink 和澳大利亚税务局(ATO)使用的“声纹”安全系统其实是可以“被欺骗”的。

警方:“小心陌生电话,社交媒体的个人信息不公开!”

的确,在 ChatGPT、GPT-4 引领的浪潮之下, AI 提速科技变革带来诸多便利,也难免让众人惶恐不安,例如:

-

谷歌 DeepMind 基于深度学习的原始音频生成模型 WaveNet,在语音合成的声学模型建模中,可直接学习到采样值序列的映射,能高度模仿人类声音;

-

AI 语音克隆算法项目 MockingBird,号称能“5 秒内克隆你的声音并生成任意语音内容”。

值得关注的是,当 AI 语音克隆技术用于正当目的时,能帮助语音合成、语音翻译、语音恢复等,但它用于非法目的时,将为伪造证据、欺诈勒索等行为提供可能。

知名安全机构 McAfee 对来自七个国家的 7054 人,针对 AI 诈骗进行了调查,结果显示:近 1/4 的人遇到过某种形式的 AI 语音诈骗。

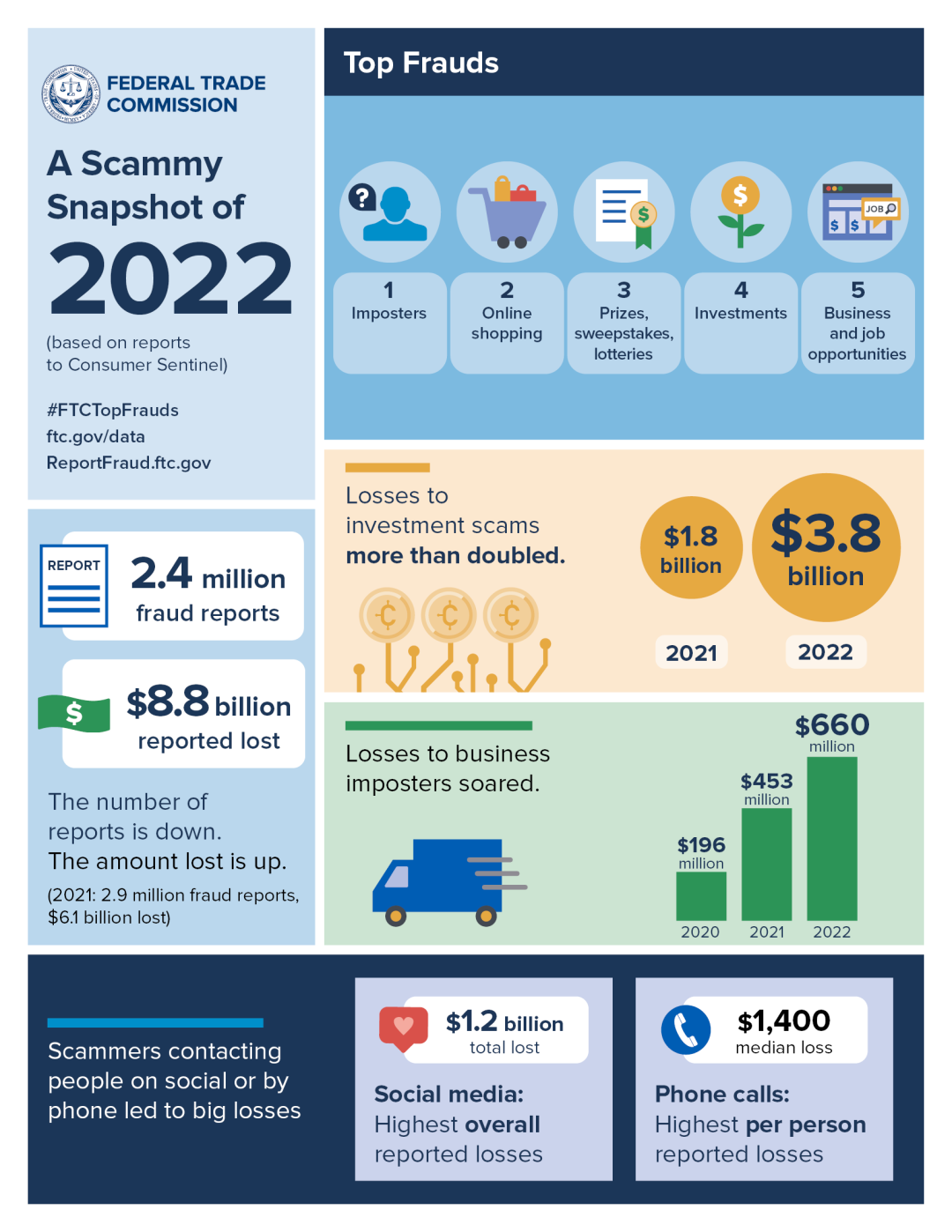

据联邦贸易委员会最新发布的数据显示,在 2022 年因欺诈损失金额的案件中,“冒名顶替者诈骗”的数量排名第二,全年共损失了 26 亿美元。此外,在 240 万份欺诈报告中,最常见的是冒名顶替诈骗报告。

联邦调查局专家表示,诈骗者经常在社交媒体上寻找目标。

为了避免成为此类骗局的受害者, FBI 凤凰城办公室的助理特工 Dan Mayo 敦促大家:社交平台的个人资料保持在私人模式,不要向公众公开。

Dan Mayo 认为:“必须把那些东西锁起来,一旦公开将会面临被骗的风险,因为他们会寻找有关你的公开信息,并随之深入了解你。”

与此同时,对于那些不熟悉的区号的电话号码、国际号码,需要格外警觉。

目前,虽然尚不清楚有多少人接听到通过 AI 语音克隆进行假绑架的诈骗电话,但 Dan Mayo 表示这种情况“每天都在发生”。

针对“ AI 语音克隆进行假绑架”的相关新闻,许多网友也展开了相关讨论。一些人认为:“非常担心家中的老人和小孩被‘诈骗’”;“感觉如果真的用了完全逼真的声音进行‘勒索’,完全是防不胜防。”还有网友调侃道:“现在是防火防盗,还要防 AI 了!”

对此,你怎么看?可以在评论区留言和讨论。

参考链接:

https://edition.cnn.com/2023/04/29/us/ai-scam-calls-kidnapping-cec/index.html

https://www.theguardian.com/us-news/2023/jun/14/ai-kidnapping-scam-senate-hearing-jennifer-destefano

https://nypost.com/2023/06/14/ariz-mom-recalls-sick-ai-scam-in-gripping-testimony-to-congress/

https://www.ftc.gov/news-events/news/press-releases/2023/02/new-ftc-data-show-consumers-reported-losing-nearly-88-billion-scams-2022

原文链接:https://blog.csdn.net/csdnsevenn/article/details/131238027?ops_request_misc=%257B%2522request%255Fid%2522%253A%2522169900313816777224421048%2522%252C%2522scm%2522%253A%252220140713.130102334.pc%255Fblog.%2522%257D&request_id=169900313816777224421048&biz_id=0&utm_medium=distribute.pc_search_result.none-task-blog-2~blog~first_rank_ecpm_v1~times_rank-11-131238027-null-null.nonecase&utm_term=%E6%BE%B3%E6%B4%B22023