ChatGPT 持续成为大家关注的焦点,开启通用人工智能(AGI)之门。北京交通大学桑基韬教授和于剑教授撰写的《从ChatGPT看AI未来趋势和挑战》,详述了ChatGPT 的“能”与“不能”,AI中什么是“真”以及AI的未来趋势,非常值得关注!

在人工智能领域,ChatGPT 作为一种重要的技术突破,引起了广泛的关注.本文将探讨 ChatGPT 在人 工智能发展中的地位及其对未来 AI 的影响.首先,介绍了 ChatGPT 所展现出的优秀对话生成能力,使其几 乎可以胜任所有自然语言处理任务,并将作为数据生成器、知识挖掘工具、模型调度员、自然交互界面在各 种场景得到应用.接着,分析了其在事实错误、毒害内容生成、安全性、公平性、可解释性、数据隐私等方 面的局限,并讨论了作为辅助人类工具的 ChatGPT 明确能力边界和提高能力范围的重要性.然后,从概念经 典表示对真定义进行了分析,并从概念三指不等价的角度阐释性了 ChatGPT 无法区分真假的原因. 在论述 AI 未来时,从拓展应用、克服局限、探索理论分析了中短期技术趋势,并从感知、认知、情感、行为智能四个 层面的关系讨论了长期发展路径. 最后,探讨了 ChatGPT 作为认知智能的代表,对包括认知成本、教育要求、 图灵测试认识、学术界的机遇与挑战、信息茧房、能源环境问题和生产力提升等方面可能产生的影响.

目录:

-

1 ChatGPT的“能”:生成

-

2 ChatGPT的“不能”:负责

-

3 什么是“真”?

-

4 AI的未来

-

4.1 中短期技术趋势

-

4.1.1拓展应用

-

4.1.2克服局限

-

4.1.3探索理论

-

4.2 长期发展路径

-

5 ChatGPT的影响

[1]桑基韬,于剑.从ChatGPT看AI未来趋势和挑战[J/OL].计算机研究与发展:1-10[2023-04-18].http://kns.cnki.net/kcms/detail/11.1777.TP.20230414.1444.003.html.

引言

2022 年 11 月 30 日,OpenAI 公司发布了一款名 为 ChatGPT 的软件.该软件在发布后的 5 天内,用户 数量就超过了 100 万,2 个月内活跃用户数更是突破 了 1 亿,成为了迄今为止增长速度最快的应用软件. 该软件几乎可以完成自然语言处理的所有任务,因 此在营销、客服、教育、娱乐、咨询、翻译等行业 有着广阔的应用前景.这一成功也激励了OpenAI首席 执行官 Sam Altman,他于 2023 年 2 月 24 日发表了 一篇名为“Planning for AGI and Beyond”的文章, 认为 AGI(Artificial General Intelligence,通用人工 智能)是 AI systems that are generally smarter than humans,需要开始为 AGI 的到来做准备.AGI 会是 AI 的未来吗?本文将对此进行讨论.

1 ChatGPT 的“能”:生成

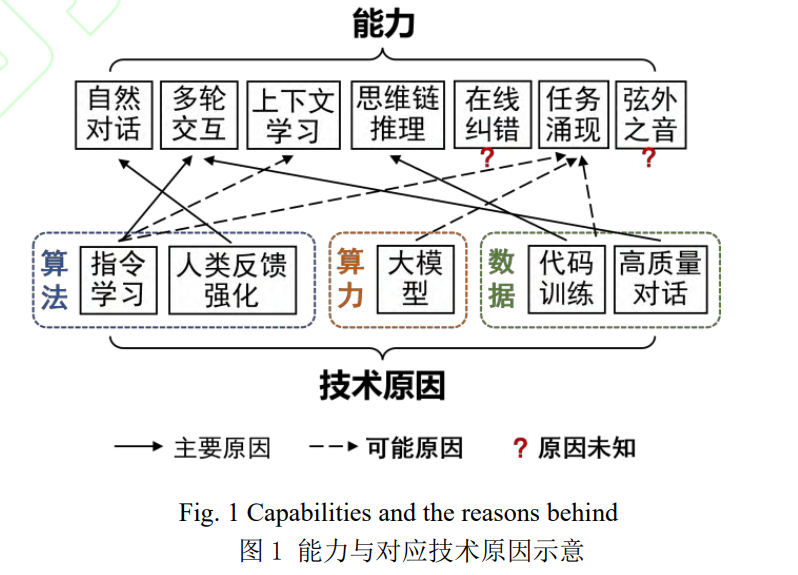

比尔盖茨将 ChatGPT 誉为自 1980 年现代图形桌 面环境 GUI 问世以来最具革命性的科技进步.如果说 上一次让 AI 火出圈的 AlphaGo 所展现出的是在特定 领域的“专”,这一次 ChatGPT 展现出的则是 AI 在 广泛应用场景的“通”:这个“通”以正常人都会、 都懂、都能体验的对话形式呈现,让 AI—特别是自 然语言处理技术进入主流用户群,孕育出了这一现 象级产品.具体而言,ChatGPT 在对话过程中展现出了自然对话、多轮交互、上下文学习、思维链推理、 实时反馈在线纠错、涌现出适应未训练任务以及 GPT-4 中新出现的理解弦外之音的能力.

ChatGPT 背后的思想其实很简单:将所有语言任务归为对话任务,将对话任务归为文字接龙的生成问题 . 自 然 语 言 处 理 领 域 的 学 者 普 遍 认 为 , ChatGPT 展现出的优秀对话生成能力对传统研究方 法产生了巨大挑战. 1)从目标上看,自然语言处理 旨在让计算机能够以文字或语音的方式与人类进行 有效交流;而对话是人类日常生活中最基本的交流 方式,实现了人机自然对话在一定程度上便达到了 自然语言处理的核心目标.2)从任务类型上,自然 语言处理可分为自然语言理解和自然语言生成两大 类.在谷歌的 T5 模型[1]推出之后,两类任务统一为单 项语言生成的文字接龙形式.自 GPT-1 起,OpenAI 就 一直坚持采用基于解码器结构的自回归语言模型, 这种模型在处理单向语言生成问题方面具有天然的 优势.所以 ChatGPT 可以处理以前不同赛道的语言处 理任务,比如翻译、问答、摘要、扩写、写作、润 色、代码生成、语句分析、段落理解等.

当然,ChatGPT 能够实现如今顺畅自然的人机 对话,不仅源于其对 GPT 单向语言生成技术路线的 持续发展,还依赖于算法、算力和数据等多方面的 支持. 由于 ChatGPT 并未对模型进行开源,也没有发 布论文透露具体细节,我们只能基于 OpenAI 已公开 的 GPT 系列技术发展路线来推测这些能力背后的潜在原因. 图1展示了部分 ChatGPT 已展现出的能力及 其背后主要技术原因的对应关系. 值得关注的是, ChatGPT 许多能力背后的原因仍在探索过程中. 关于上下文学习的能力,有学者认为模型从提示词 (prompt)提供的示例中确定了待解决任务的自然语言 指令(instruct),从而在无需微调模型的情况下提升了 问题回答的质量[2] .关于任务涌现和多任务迁移能力, 一方面,有学者认为指令学习、大规模预训练和数 据集多样性共同促进了模型在新任务的泛化能力[3] . 例如,通过在大量不同类型和指令任务上进行微调, 模型学习到了一定程度的通用能力,从而能够泛化 到未见过的指令和场景.另一方面,不同任务的划分 具有一定的主观性,其本质上都可以建模为统一的 自然语言生成任务.大型预训练语言模型通过学习大 量训练数据,掌握了丰富的语言知识和多种任务之 间的共性,进而利用这些共性来提高不同任务的性 能.然而,一些问题仍然没有明确答案,例如:何种模型规模和训练数据量阈值可以产生任务涌现能力?涌现能力与模型规模和训练数据量之间的量化关系 如何?同时,其他一些能力,如在线纠错、理解弦 外之音等,其背后的原因仍然是个谜.

OpenAI 首席科学家 llya Sutskeve 最近在与英伟 达 CEO 黄仁勋的访谈中对 ChatGPT 能力学习进行了 解释:“ChatGPT 通过学习文本中的统计相关性,获 得了这个世界的一个压缩、抽象、可用的映射表 达”.这让我们不禁思考:ChatGPT 是否学到了人类 文字符号世界的暗知识(tacit knowledge[4]).Michael Polanyi 在他的这本认识论著作中曾提到:“We can know more than we can say(我们所知者,远多于所 能说者)”.可以确定的是:机器学习模型通过统计海量符号语料中的规律,能够学习到词汇、语法、 乃至一定程度的上下文和常识知识.问题是:随着语 料规模的不断增加和统计规律的持续积累,模型所 建立的世界表达分辨率越来越高、维度越来越丰富 时,是否真的有可能学习到人类情感、道德观念等 支撑整个世界运行的更复杂的暗知识?

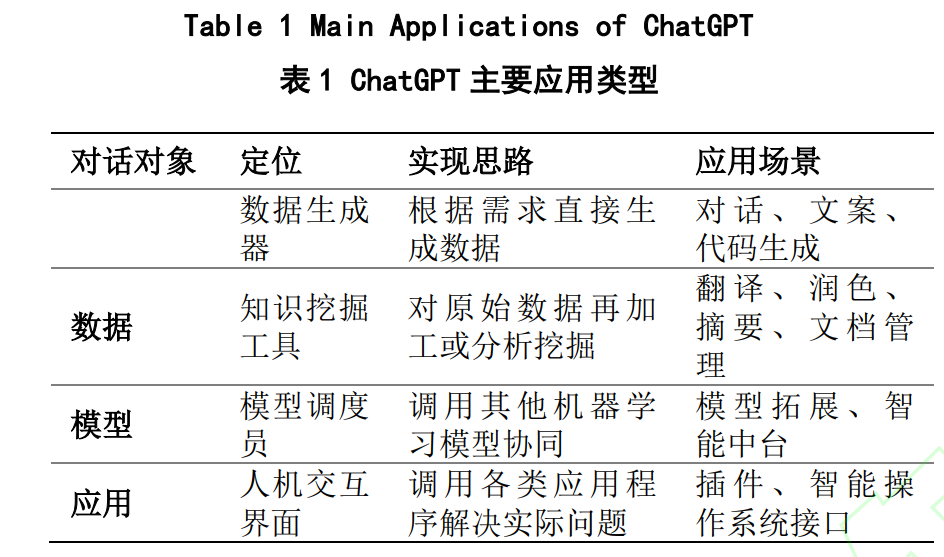

在学术界积极探索 ChatGPT 能力背后的技术原 因的同时,工业界已在欢迎这项新技术,并将其优 秀的对话生成能力融入各种应用场景.根据 ChatGPT 对话的对象和本身的定位,我们将这些应用分成 4 个层次(如下表 1 所示):

1) 数据生成器,根据需求直接生成数据.此类应用 仅输入用户需求,利用 ChatGPT 的生成能力返回特 定类型的数据.由于思路简洁且实现容易,数据生成 类应用在 ChatGPT 发布之初就大量出现.主要应用场 景包括对话生成(客服、虚拟数字人)、文案生成 (法律文书、营销策划广告)和代码生成等.典型的 成功案例包括写作助手 Notion AI、营销文案生成工 具 Jasper.ai.

2) 知识挖掘工具,对数据进行再加工或分析挖掘. 此类应用同时输入用户需求和待处理的原始数据, 利用 ChatGPT 强大的自然语言处理能力返回经过加 工的数据或挖掘出的新信息.知识挖掘类应用可以分 为 离 线 和 在 线 两 种 形 式 . 离 线 应 用 通 过 调 用 类 ChatGPT API 分析和挖掘私有数据等专业领域语料构 建知识库,为进一步应用提供知识支持.在线应用的 主要场景包括翻译、润色、摘要生成、文档管理等. 一些典型案例包括搜索引擎摘要插件WebChatGPT、 文档分析工具 ChatPDF 以及 OpenAI 官方随 GPT-4 发 布的摩根士丹利策略分析师.

3) 模型调度员,调用其他机器学习模型共同解决 用户需求.此类应用同时输入用户需求、待处理数据 以及多个可调用的机器学习模型,通过 ChatGPT 作 为人类与其他模型间的连接,设计解决方案、调用 并管理其他机器学习模型,共同完成用户需求并输出结果.这方面的典型案例是微软近期发布的系列多 模态解决方案 Visual ChatGPT[5]、MM-ReAct[6]和 HuggingGPT[7],其通过调度其他视觉基础模型来协 同完成视觉和语音任务.此外,AI 赋能一直以来的一 个痛点问题是,智能中台需要整合不同模型和技术, 并根据业务需求扩展新的模型.ChatGPT 有望实现智 能中台的升级:提供友好的开发/业务人员界面、实 现模块化模型管理、简化技术集成和部署,从而提 高 AI 赋能效率.随着 ChatGPT 应用探索的深入,相 信模型调度员类型的应用将越来越受到关注.

4) 人机交互界面,调用更广泛的应用程序帮助人 类解决实际问题. 第一种形式是将 ChatGPT 嵌入到特 定应用中,从而极大地提升自然交互体验,如微软 的 365 Copilot 和 Copilot X 分别将 ChatGPT 融入 Office 和 Github.第二种形式是在 ChatGPT 搭建的自 然语言交互框架上开发各类信息服务应用,去年 10 月推出的开源库 LangChain 和 OpenAI 最近发布的插 件集 Plugins 都是大型语言模型应用开发框架的典型 尝试.正如 Windows 和 Android 分别是桌面和移动时 代的操作系统,ChatGPT 有望成为智能时代的操作 系统接口.进一步畅想,如果把语言分为人类之间沟 通的自然语言和人与计算机之间沟通的计算机语言, ChatGPT 在一定程度上统一了二者:用自然语言实 现了人和计算机之间的沟通,不得不说“自然语言 编程(Natural Language Programming)”这一新词非常 贴切.从这个角度看,我们甚至可以大胆预测:人机 交互界面将从磁带、键盘字符、鼠标图形全面进化 到自然语言时代.

以上围绕对话生成讨论了 ChatGPT 的具体能力、 背后的技术原因以及在不同定位下的应用形式.尽管 “对话生成”提供了无限的想象,但 OpenAI 的野心 显 然 并 不 止 于 此 . 从 名 称 和 发 布 时 间 点 来 看 , ChatGPT 似乎只是一种过渡性技术的产品形式.在以 对话这种产品形式向主流用户群展示了强大的技术 实力之后,OpenAI 新发布的 GPT-4 并未继续在对话 生成功能上炫技,而是悄然接入了各类官方应用.

从生物学角度,语言和智能的演化过程相互促 进.人类智能在很大程度上依赖于高度复杂的语言系 统.语言作为思维的载体和智慧的外在表现,其运用 能力很大程度上反映了认知能力和智能水平.语言习 得是认知发展的重要组成部分.儿童在成长过程中通 过习得语言来理解世界,并逐渐掌握其他认知技 能.ChatGPT 等技术在语言生成能力的持续提升能将 人工智能带到什么高度,让人非常期待.

2 ChatGPT 的“不能”:负责

能力越大,责任越大. ChatGPT 展现出的强大能 力让主流用户群欣喜、学术界惊讶、工业界狂热.这 些能力让我们在使用它时感受到了与以往技术不同 的体验.回顾人类历史上的几次技术革命,从早期的 石器、金属器具、机械设备、电气设备到近几十年 的计算机、互联网和智能手机,每一个阶段所发明 的工具都对人类生活产生了深远影响.在使用这些工 具时,我们可以清楚地意识到它们作为工具的定位, 即辅助人类来完成任务.然而,在使用 ChatGPT 的过 程中,我们经常会产生一种与另一个人对话的错觉, 尤其是当类似 Plugins 这类功能使其能够像人类一样 利用其他工具进行自我增强的时候.埃隆-马斯克在使 用 ChatGPT 后的感受是“好到吓人”.这种独特的体 验无疑将加速技术融入人类社会的进程.正如 OpenAI 自己对 ChatGPT 的评价:“尽管 ChatGPT 还没有实 现真正的智能,但它让人体验到了真正的智能实现 后,每个人都能用它做各种他们想做的事情的滋味.”

整个 2023 年 3 月被各种生成式 AI 技术和产品 的发布充斥:Meta Alpaca、GPT-4、PaLM-E、文心 一言、Office Copilot、Midjourney V5、英伟达新显 卡 、 Github CopilotX 、 ChatGPT 插件、 Security Copilot 等.我们可以预见相关技术的应用领域将迅速 拓展、应用程度将大幅度加深.人们在享受技术带来 的便捷和生产力提升的过程中,对技术的态度将从 习惯逐渐转变为依赖.而当人们开始依赖这些技术代 替自己学习、思考、甚至决策时,有两个问题摆在 我们面前:技术是否已经做好准备承担责任?人类对技术的信赖是否超出了它的能力?实际上,ChatGPT 在使用过程中已被发现存在 诸多问题:如数学计算、未来预测、时空物理现实 推理等方面能力的局限,以及事实错误(幻觉)、生成 毒害内容等方面的不可控[8] .下面从可信 AI 的 4 个维 度对 ChatGPT 存在的问题展开讨论.

1) 安全性. OpenAI 在官网上将“安全”列为五个目 录之一,在随 GPT-4 发布的报告中批露了其在技术 和评估两方面都设立了专门的安全小组,足见对安 全性的重视.然而,和所有机器学习模型一样, ChatGPT 仍存在着被对抗攻击的风险.一种典型方式 是提示语注入攻击(prompt injection attack):在提示 语中混入恶意指令,可能绕过 ChatGPT 的安全机制, 迫使其执行意外动作,如泄露敏感信息、输出有害 内容等.例如,ChatGPT 驱动的新 Bing 在受到攻击后 泄露了其内部代号“Sydney”;ChatGPT 被诱导规划 抢劫方案,甚至提供了购买抢劫道具的链接等.

2) 公平性.在 ChatGPT 之前,OpenAI 的文生图DALL-E系列曾被发现存在输出性别和种族歧视内容 的问题.类似地,GPT-2、Bert、RoBERTa 等语言模 型在一个测试项目中也被发现具有严重的性别偏见 倾向[9] .尽管目前尚无系统性研究分析 ChatGPT 在性 别和种族偏见方面的表现,但已有研究发现它存在 明显的语言敏感性:例如,当用日语和俄语分别询 问一个日俄争议岛屿的归属问题时,ChatGPT 给出 了截然不同的答案[10].

3) 可解释性. ChatGPT 的思维链能力可以在答案中 同时呈现推理过程,这在部分程度上解决了实验室 环境下模型可解释性的问题.然而,需要注意的是, 这种推理过程的解释是面向用户的,并不一定与模 型的实际运行机制准确对应.此外,ChatGPT 仍存在 很多尚未解释的行为,包括自我在线纠错、理解弦 外之音等能力,以及出现事实错误(幻觉)等问题.由 于大模型本身的复杂性以及仅通过 API 提供服务的 现实限制,ChatGPT 对于用户和开发者都是完全的 黑箱.随着应用场景的拓宽和加深,现有的解释性水 平可能难以满足透明度和回溯性等的要求.

4) 数据隐私. 涉及 2 个方面:训练阶段的数据侵权 和推理阶段的隐私泄露.大模型训练需要的海量数据 多来自网络,其中难免包括未经授权的版权保护内 容.ChatGPT 虽然可能避免语句层面的抄袭,但难以 避免语义上的深度抄袭.2023 年,大模型领域发生了 多起版权侵权案.例如,三名艺术家指控 Stable Diffusion 使用其版权作品作为训练数据,而微软和 OpenAI 因其开发被指控其开发的编程助手 Copilot 涉 嫌复制 Github 上的开源代码而受到指控.在推理阶段, 攻击者有可能通过逆向攻击等手段,利用模型输出 的结果来反向推导出训练数据中的隐私信息.GPT-2、 BERT、RoBERTa 等语言模型均被发现存在数据隐私 泄露的风险[11] .随着模型规模和功能多样性的增加, 这种风险可能进一步加大:模型规模越大,其记忆 能力越强;功能越多样化,可被利用的信息和攻击 方式也越丰富.ChatGPT 自身代号的泄露便证实了这 一点.

从生成式 AI 模型选择的技术路线和当前发展水平看,这些问题既可以归结为大型语言模型固有的结构局限,也可以归结为将符号任务统一建模为对 话问题的过度简化.关于这条技术路线的未来发展, 同时存在着乐观和悲观的观点.乐观派认为,人脑神 经元突触连接总数约为一百万亿,随着语言模型参 数量的不断增加,模型可能在某个时刻实现量变到 质变的跃迁,这些问题也会自然消失.然而,包括乔 姆斯基、Stuart Russell 等大佬在内的悲观派则持相反 观点,他们认为端到端的深度学习与人类进行推理和使用语言的方式有着巨大差异,依靠更多数据和 算力无法消除这些缺陷或实现真正的智能.

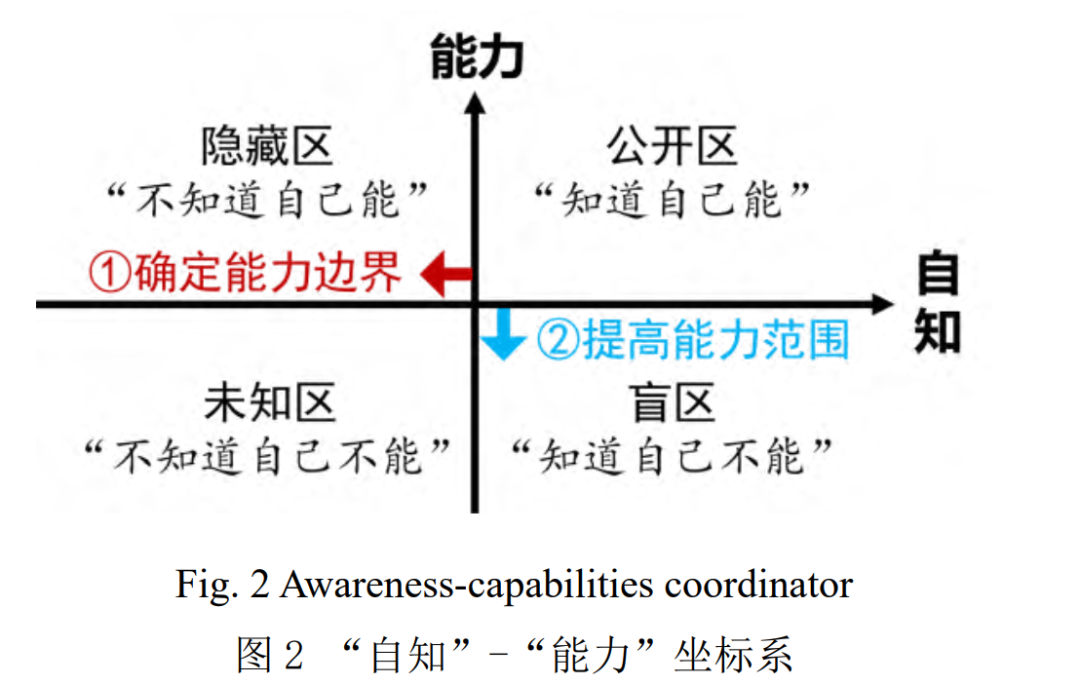

不讨论技术路线的选择或者观点的对错,不管 生成式 AI 模型的能力演进到何种程度,其定位始终 是帮助人类更好地完成任务的工具.作为工具,首先 应该明确能力边界,即“做自己能做的事”.在认知 心理学中,约瑟利窗口(Johari Window)将人际关 系划分为公开区、盲区、隐藏区、未知区四个象限 [12] .参照这种方法,如图 2 所示,我们可以沿“自知” 和“能力”两个维度绘制一个坐标系,智能工具处 理的任务将落在其中一个象限内.当任务落在“自知” 负半轴的两个象限时,可能会出现不可预知的问题:在隐藏区时,模型“不知道自己能”,可能在收到用 户反馈后将原本正确的答案改为错误,或接受用户 错误反馈的引导;在未知区时,模型“不知道自己 不能”,可能会产生事实错误幻觉,一本正经地胡说 八道.

根据“自知”-“能力”坐标系,首先需要明确 能力边界,即扩大“自知”正半轴两个象限的覆盖 范围,使更多任务落入公开区和盲区.在公开区时, 模型可以自信地回答用户的问题;而在盲区时,模 型应该承认能力缺陷,避免回答不知道的问题,或 者虚心接受用户的反馈引导.PAL[13]是开发隐藏区的 一个例子,通过在提示词中注入包含推理过程的程 序示例,成功挖掘了模型在原本容易回答错误的数 学推理类任务的解决能力.在明确能力边界后,需要 进一步提升模型的能力,即扩大“能力”正半轴、 尤其是第一象限的面积,使更多的任务从盲区转移 到公开区.缩小盲区的一个例子是 ReAct[14],它将推 理和行动结合,通过调用搜索等插件从网络等外部 资源中逐步、有选择性地收集和处理新信息,从而 提高了模型在各种复杂场景下的解决能力.另一个最 新提出的框架 Reflexion[15],它在 ReAct 基础上加入 了自省 Reflect 功能,通过试错的方式,在寻找自身 能力边界的同时,探索新任务的解决方案.这是一个 在同时确定能力边界和提高能力范围方面很有意思的尝试.

当然,“自知”-“能力”坐标系只是一个理想 和简化的框架.人类在执行任务时,通常会考虑诸如 道德、伦理、公平等价值观.而 ChatGPT 并不具备人 类的价值观和判断力,可能会生成与事实相悖的错 误信息和误导性的建议.比如,当用户询问“林黛玉 是如何倒拔垂杨柳的”,ChatGPT 会一本正经地介绍 相关具体细节.事实上,《林黛玉倒拔垂杨柳》是一 部网络小说,中文论坛上也有许多对这一虚构情节 的讨论.模型在学习这些语料时无法区分虚构和现实, 因此产生了这个尴尬的回答.随着 GPT-4 的发布,可 以预见 ChatGPT 将有能力在符号世界中实现自动化 生成.然而,它依然不能确保所生成内容的真实性, 自然更无法对生成结果承担责任.

3 什么是“真”?

为了解释为何 ChatGPT 无法保证结果为真,首 先需要探讨什么是“真”.“真”的定义有很多,本 文采用亚里士多德的经典定义[16]:说是者为非,非 者为是,即为假;而说是者为是,非者为非,即为 真. 基于此,Tarski 提出一个更形式化的“真”的定 义[17]:

X 是真语句当且仅当 p, 其中 p 代表任意语句,X 是语句 p 的名称. 即,一个语句是真的,当且仅当它描述的情况确实 发生了.比如:“树在长芽”是真语句当且仅当树在 长芽,即“树在长芽”是真语句当且仅当树在长芽 确实发生了.

但是,这个看似合理的“真”的定义却隐含矛 盾.Tarski 转述了乌卡谢维茨的加强版说谎者悖论:

令 C 是“C 不是一个真语句”的名称,因此, 有如下两个假设:

1)α假设:C=“C 不是真语句”;

2)β假设:“C 不是真语句”是真语句当且仅 当“C 不是真语句”.

综合α假设与β假设,即可以得到:C 是真语 句当且仅当“C 不是真语句”,悖论.

Tarski 关于“真”的定义和上面的推理似乎都没 有问题,那问题出在哪里呢?我们认为问题出在概 念的定义上,因此需要仔细考察概念的定义.

众所周知,概念的经典表示由三部分组成:符 号表示、内涵表示和外延表示.其中,概念的符号表 示由概念名称表示,概念的内涵表示由描述概念特 性的命题表示,概念的外延表示由概念所包含的实 例的经典集合表示.比如,“偶数”这个概念,其中文符号表示是“偶数”这个词;内涵表示是 “能被 2 整除的整数”这个命题;外延表示是包含所有偶数 的集合:{…,-6,-4,-2,0,2,4,6,…}.

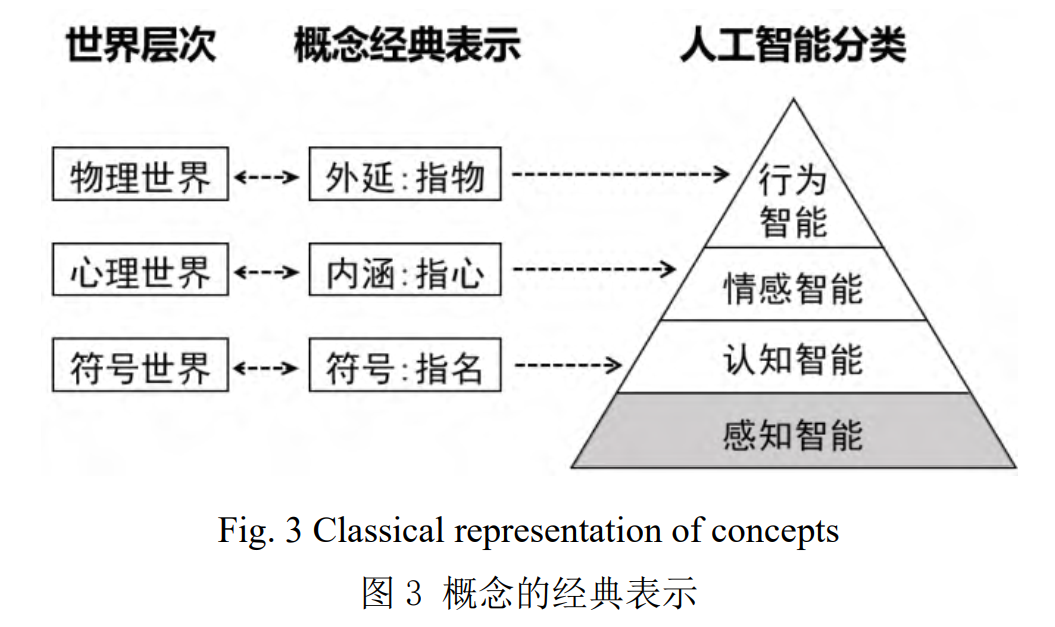

如图 3 所示,根据经典表示,每个概念具备 3 种 功能:指名、指心和指物,同时对应着波普尔的 3 个世界:符号世界、心理世界和物理世界[18] .概念的 指名功能,是指每个概念都指向认知世界或符号世 界中的一个实体,用所指对象的特定符号名称来表 示.这些符号名称可以组成各种不同的语言.概念的指 心功能,是指每个概念也指向人类心理世界中的实 体,代表这个概念在心理世界里的对象表示.概念的 指物功能,强调概念与物理世界中的实体之间的对 应,这些实体遵循物理世界的规律,可以独立于人 的主观感受. 如果从概念的表示来实现人工智能,指名指物 指心对应了 3 条路径:符号主义、连接主义和行为 主义.如果从概念的功能角度来对人工智能分类,可 以分为认知智能、情感智能和行为智能.认知智能实 现了概念的指名功能,即处理和理解符号世界的问 题.情感智能则实现了概念的指心功能,主要关注心 理世界中的问题.而行为智能则体现了概念的指物功 能,主要解决物理世界中的问题.然而,如果要实现 概念的三指功能,必须首先解决机器的感知问题.解 决机器感知问题是最基本的人工智能,通常被称为 感知智能.感知智能主要关注机器的输入输出处理, 是实现认知智能、情感智能和行为智能的基础.

在概念的经典表示下,概念的指名、指心与指 物功能是等价的,其符号表示、内涵表示和外延表 示在功能上也是可以互换的.这是因为概念的经典表 示存在 6 条预设:

1) 概念的外延表示可以由集合{x1,x2,⋯ ,}表示;

2) 概念的内涵表示存在且用命题∀xP(x)表示;

3) 概念的名称存在,且用符号表示 A;

4) 概念的外延表示与内涵表示同名:A={x1,x2, ⋯ ,}=“∀xP(x)”;

5) 概念的表示唯一,即同一个概念的表示与个体无关:∀α(A α=A), α 代表一个人;6) 概念的指称等价,即其内涵表示与外延表 示在指称对象的时候功能等价∀x(x∈A↔P(x)),其中, A={x1,x2,⋯ ,}.

根据上述概念的经典表示,可以知道概念的指 名、指心与指物功能是等价的.在日常生活中,这种 情况非常普遍,因此说真话是通常的情形.罗素曾给 出一个清晰的论证[19]:“除非假定说真话是一种通常 的情况,否则没有人能够学会说话:假设当你的孩 子看到一条狗时,你随意地说出‘猫’、‘马’或者‘鳄 鱼’,那么当他看到的不是一条狗时,你无法通过能 通过说‘狗’来欺骗他.因此,说谎是一种派生的行为, 它预设了说真话是通常的规则.”在上述罗素的论证 里,可以清楚地看到,其预设了概念的指名与指物 等价,即假设概念的三指等价是真的必要条件.

如果概念的指名、指心与指物功能等价,则可 以认为:认知智能、情感智能与行为智能等价.这意 味着一旦实现了认知智能,也就同时实现了情感智 能和行为智能.同时,人工智能的三条实现路径—符 号 主 义 、 连 接 主 义 和 行 为 主 义 一 也 是 等 价 的.ChatGPT 和 GPT4 的出现,表明认知智能已经取 得了巨大的进步. 如果概念的三指等价,那么认知 智能的巨大进步预示着情感智能和行为智能将取得 同样的巨大进步.从这个角度看,实现 AGI 似乎也有 可能性.

然而,乌卡谢维茨悖论告诉我们概念三指等价 在逻辑上并不永远成立:它内蕴矛盾.Tarski 的真定 义实际上等价于如下命题:概念的指名功能为真当 且仅当概念的指物功能为真.显然,概念的经典表示 也预设了 Tarski 的真定义. 仔细分析乌卡谢维茨悖论 的逻辑推理,可以发现 α 假设与 β 假设都预设了概 念的指名功能为真与概念的指物功能为真等价,这 必然导致悖论.实际上,在概念的三指等价条件下, 针对包含算术系统的逻辑系统,哥德尔证明了不完 全性定理,而Tarski得到了著名的真之不可定义定理. 这些都说明在复杂一点的符号系统内部,不可能解 决 何 为 真 何 为 假 的 问 题 . 因 此 , 从 理 论 上 讲 , ChatGPT 和 GPT4 同样无法解决真假问题.因此,我 们必须放弃概念的三指等价假设.一旦放弃了这个假 设,就会发现认知智能、情感智能与行为智能是不 可能等价的.实际上,现实生活中,这三种智能从未 等价过.

4 AI 的未来

很多人认为 ChatGPT 已经开启了第四次技术革 命.面对这种尺度的变革,我们很难在早期准确预测未来的发展.在这里,我们仅从中短期技术趋势和长 期发展路径两个方面,来探讨在当前阶段我们对这 一技术的理解.

4.1 中短期技术趋势

OpenAI 发明 ChatGPT 对于人工智能领域的影响, 可以类比哥伦布发现了美洲大陆.在哥伦布发现美洲 之前,探险家们一直渴望着探索新大陆,并尝试使 用各种方法去寻找它.然而,即使是经验非常丰富的 探险家,也并不确定新大陆是否真实存在,以及哪 种航海方法更为有效.哥伦布的成功不仅坚定了后来 探险家们的信心,更在一定阶段内统一了寻找新大 陆的方法:在新的突破性技术出现以前,看似简陋 的帆船和罗盘已经足以带领人们到达目的地.

同样地,ChatGPT 的诞生为人工智能领域注入 了信心并指明了发展方向,展示了“大力出奇迹” 的可能:通过不断扩大神经网络的模型规模和增加 数据量,可以在 AI 的道路上取得实质性的进展.在这 一目标和技术路线的共识下,我们从拓展应用、克 服局限和探索理论 3 个方面探讨人工智能领域中短 期的可能技术趋势.

4.1.1 拓展应用

1) 垂直化. ChatGPT 发布初期,人们尝试在提示 词中注入角色信息以增强垂直领域对话质量.为克服 提示词 token 数量限制以融合领域语料,有工作提出 基于LangChain框架,将领域文档切片后分布式输入. 但这种做法存在私域数据泄露风险,解决思路之一 是利用 ChatGPT 控制和调用其他领域模型来提高垂 直化能力.此外,MIT 最近提出保护隐私的迁移学习 框架 Offsite-Tuning[20],可在不访问完整模型的前提 下,在下游领域数据上微调数十亿级参数的基础模 型.对于需要构建领域模型的场景,在不泄露基础模 型和领域数据的情况下,实现对通用基础模型的领 域微调非常重要.

2) 个性化. 个性化可视为垂直化的极致,针对个 人需求和偏好的个性化微调模型能够提供更精确的 服务.典型的应用场景包括个性化推荐系统、个性化 教育辅导、个人 AI 助理等.微软于 2023 年 4 月 4 日 开源了大模型协作项目 JARVIS,旨在大型语言模型 与机器学习社区的其他模型之间建立连接.JARVIS 这 个名字让我们对钢铁侠中同名的 AI 助理产生更多联 想.如果未来个性化模型可以通过多模的人机交互来 增强,实现与人类对世界的同步感知、学习和成长, 这样的 AI 助手能够更好地理解个性化需求、情感和 行为,协助我们实现更高效的工作、学习和生活方 式.在这个过程中,我们需要解决诸如中心平台式 AI 如何保护个人数据以及在个体层面部署模型等问题.

3) 工程化. ChatGPT 的诞生某种程度上是工程 化的胜利,而它的成功无疑将进一步加速 AI 技术从 实验室研究走向工程化和产业化.从必要性上看,随 着数据量和计算资源需求的增加,工业界拥有更好 的条件主导大模型研发,相关实验室研究也需调整 研究范式和目标以适应工程化需求.从可行性上看, ChatGPT 的成功让工业界看到了 AI 技术在各行业落 地和价值实现的可能,众多开源项目和成熟技术框 架的出现则为 AI 技术工程化提供了支持.从重要性上 看,工程化是一个学科发展和成熟的标志,AI 技术 的工程化有助于进一步优化和完善相关技术,激发 学术创新活力,推动 AI 领域的整体发展.

4.1.2 克服局限

1) 多模态增强. 多模态大模型的发展逐渐以语 言模型为主,将视觉、语音等多模态信息映射到语 义符号空间进行处理.近来的多模态解决方案更是提 出直接以大型语言模型为基座来拓展多模态能力, 如 Visual ChatGPT 和 MM-ReAct 以 ChatGPT 为中心 调度其他视觉模型、PaLM-E 固定语言模型训练额外 的视觉编码器等.然而,人类在进行多模态学习时并 不完全依赖于符号空间,大脑神经网络在不同感官 区域间传递、整合信息,同时结合视觉形象、空间 关系等非符号性表示.由于多模态世界建模更为复杂, 以语言模型为主或是现有条件下的折衷.随着多模态 数据量与模型参数继续增加,期望在视觉、语音等 空间实现真正的多模态生成能力.如被细线系着的气 球照片,无需映射至语义空间,模型即可预测线剪 断后的情景.

2)人机交互增强. 有人将现在的 ChatGPT 比作 一个博览群书的神童,却从未亲身体验过这个世界. 经典的认知实验发现,与被动旁观的猫相比,具有 自由活动能力的猫可以通过主动与环境互动并获得 反馈,从而更好地学习行为能力[21] .在一项微软的最 近研究中,ChatGPT 已经能够根据人类的要求自动 编写代码并指挥无人机协助完成任务[22] .通过进一步 考虑生物学特性、身体感知和行动的影响,有望实 现与真实物理世界的双向交互,在自主行为反馈中 不断提升自身智能水平.

3) 可信增强. 之前的讨论已概括了 ChatGPT 当 前的局限和进行可信研究的必要性.可以预见,每个 大模型公司都将需要一个专注于可信的安全和伦理 团队.这就不难理解 OpenAI 的系列举措:GPT-4 在训 练完成后经过半年的评估和修正才发布、用 30 余页 技术报告介绍安全补丁 System Card,以及对模型评 估框架Evals的开源.即便如此,ChatGPT还是因隐私问题在意大利遭禁,并遭到包括马斯克和沃兹尼亚 克等上千名知名人士的联名叫停.值得注意的是,除 了安全、公平、可解释、数据隐私等经典可信问题 外,ChatGPT 还会带来模型回音壁等新问题.目前, 使用 ChatGPT 生成的对话数据进行训练已经成为公 开的秘密,甚至出现了专门收集 ChatGPT 对话的网 站 ShareGPT.其实,在人类反馈强化 RLHF 后,就有 学者提出了基于智能模型反馈强的 RLAIF 框架[23] .随 着模型规模继续增加,可供训练的自然数据面临枯 竭,模型生成标注和反馈数据在模型间的回音壁效 应将加剧可信问题.此外,垂直化、个性化、多模态 等技术趋势也会带来新的可信挑战.关于可信增强的 方案,考虑到传统 AI 测试基准已不足以评估模型能 力,我们需要尽快构建新的可信测试基准:包括可 信 benchmark 数据集和可信测试框架.此外,为了准 确评估模型的应用成熟度,我们应该研制面向大型 语言模型的可信标准,以规范不同可信等级的模型 在相应的应用场景中使用.同时,结合工程化的发展 趋势,我们可以参考软件开发周期中的测试-调试闭 环,在基础模型和下游模型两个层面进行迭代优化, 以确保模型在大规模应用场景中的可信性.

4.1.3 探索理论

1) 预训练模型机理研究.近年来,计算机视觉和自 然语言处理领域的技术框架逐渐趋同.学习范式从特 征工程、深度监督学习转向自监督预训练,模型结 构从 CNN、RNN 发展为 Transformer.针对自监督预 训练和 Transformer 结构,仍有很多基础性问题等待 研究,如自监督学习泛化理论、预训练与微调的动 态平衡分析、Transformer 结构的\定性和鲁棒性分析 等.对于 ChatGPT,除了探究在线纠错、理解弦外之 音等原因未知的能力外,还需进一步研究任务涌现 能力与模型规模以及训练数据量等的关系,为未来 模型设计和实际应用提供指导.

2) 学科交叉融合研究. ChatGPT 作为催化剂,不仅 将推动人工智能学科内部计算机视觉和自然语言处 理领域的进一步整合,而且将激发学术界和工业界 更加深入地探讨和实践人工智能和其他学科交叉融 合以及跨学科应用的可能性.以脑科学为例,结合脑 结构和人工神经网络研究,我们将更有可能揭示智 能产生的本质原因.实际上,OpenAI 的 CEO Sam Altman 早就投资了可控核聚变公司 Helion 和生物科 技公司 Retro Biosciences.科技部近期启动的 AI for Science 专项部署工作更是明确指出了将人工智能与 数学、物理、化学、天文等基础学科紧密结合,重 点攻关药物研发、基因研究、生物育种研发、新材 料研发等领域的关键问题.

4.2 长期发展路径

我们沿着概念经典表示和人工智能分类的讨论 来看 AI 未来可能的发展路径.《左传》里有句名言, “太上有立德,其次有立功,其次有立言”.显然, 立德属于心理世界,是情感智能的范畴;立功属于 物理世界,是行为智能的范畴;立言属于符号世界, 是认知智能的范畴.应该指出,这三个世界既互相独 立又相互依存.比如,符号世界也必须通过心理世界 表示才能为人所感知,同样符号世界也必须通过物 理世界显现展现才能传播.对于人而言,认知的物理 世界本身也属于符号世界的示例,没有成为符号示 例的物理对象难以被符号世界记录,同样,物理世 界也是通过心理世界被人感知.

三个世界各自都足够复杂.在符号世界中,有自 然符号、模拟符号和象征符号.其中自然符号直接用 物理世界中的对象作为符号,比如学生用书包或其 它个人物品占座.此时的书包或个人物品就有了符号 意义,属于典型的自然符号.图像、视频等是典型的 模拟符号.文字是最常见的象征符号.至于心理世界、 物理世界的复杂性,更是众所周知.

为了计算方便,通常假定概念的三指等价,即 符号世界、心理世界、物理世界三界同构.比如,符 号主义的物理符号系统假设认定物理符号系统具有 产生智能行为的充要条件,这暗示了符号世界与物 理世界等价.连接主义认为只要能模拟大脑的思考功 能就足够了,实际上它假设了心理世界(或其子集) 与物理世界等价.行为主义则认为只要能在物理世界 实现智能,不需要知识、表示和推理,只需要感知 和行动,这意味着符号世界、心理世界是物理世界 或其子集.但是,3 个世界并不同构.比如,乔姆斯基 曾经写过一个著名的句子:“Colorless green ideas sleep furiously.”这个句子在符号世界可行,但在心 理世界和物理世界就失去了可行性.因此,3 个世界 同构假设仅是一种有用的简化,并不总是成立。

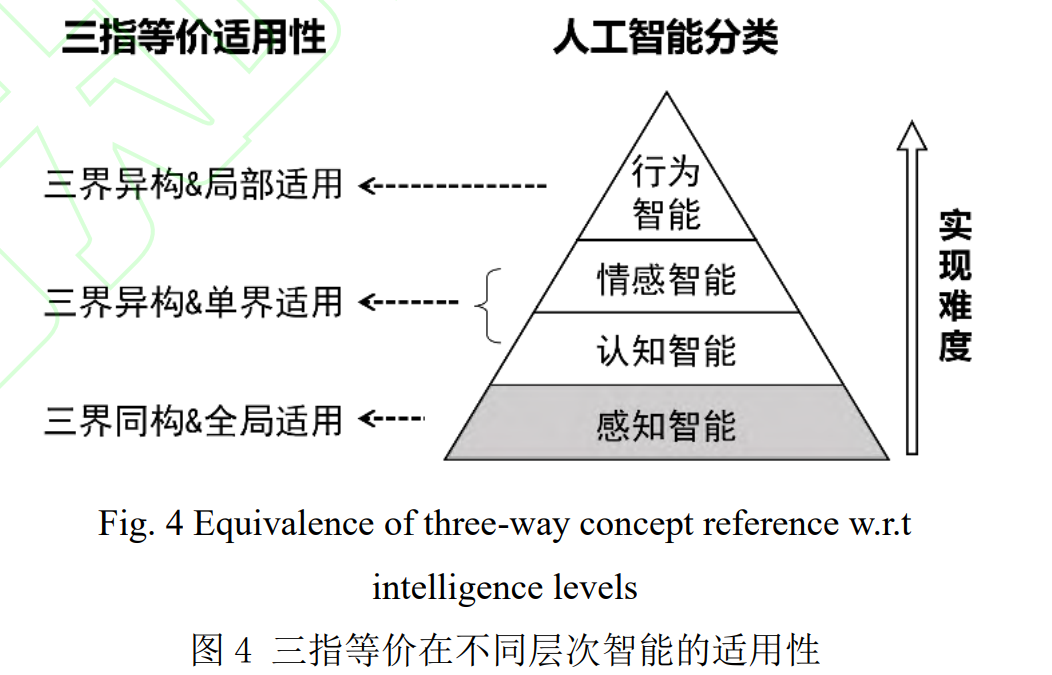

由于 3 个世界并不同构,它们之间的关系相当复杂.这导致在 3 个世界中实现智能的难度也大为不 同.从共性上讲,无论在哪个世界实现智能,首先必 须解决最基础的感知问题,即输入输出问题.从难度 上看,感知智能、认知智能、情感智能、行为智能 依次增加.原因很简单:感知智能保持了 3 个世界同 构假设.从认知智能开始,我们必须放弃 3 个世界同 构的假设,只能假设 3 个世界的某些受限子集同构. 认知智能旨在解决符号世界的智能问题,其实现主 要受制于符号世界的规律,这些规律可能是显知识, 也可能是暗知识,但认知智能依然在符号世界内预 设概念的三指等价.情感智能主要解决心理世界的智 能问题,除了受制于心理世界外,也受制于情感所 在的物理个体,即情感必须在认知层面具备具身特 性.理论上,西施难以与青蛙共情,夏虫不能与秋雁 同语.对于机器来说,情感智能是基于认知智能的, 情感智能也是依赖于机器内部的符号操作.仅有认知 智能并不能实现情感智能,情感智能的实现难度髙 于认知智能,情感智能预设心理世界内的概念三指 等价.行为智能主要解决物理世界的智能问题,不但 受限于作为行为主体的自身物理条件,也受限于其 所处的物理环境,约束最多,因此实现难度最大.莫 拉维克悖论实际上是对行为智能实现难度最大的一 个简单说明.对于行为智能来说,任一概念的三指等 价都需要检验,任一概念的三指等价都不能先验预 设成立,这正是莫拉维克悖论背后隐藏的挑战.图 4 比较清楚地说明了概念的三指等价性从默认成立到 必须检验所对应的不同智能阶段。

根据以上分析,人工智能的发展路径可以预测 为:首先成熟的是感知智能,次之为认知智能,再 次为情感智能,最后是行为智能.这与人工智能目前 的现状相符.当前,感知智能的问题已经大部分解决, 已经融入人们的日常生活.得益于 ChatGPT 等技术, 认知智能的问题已经初步解决,即将走入人们的生 活.情感智能的问题部分解决,受限可用,比如在三 界同构假设成立时,可以使用类 ChatGPT 技术.行为 智能的问题尚极具挑战性,在目前的情况下可用性 受到严重限制,如在工厂等封闭场景下部分可用, 距离人们的日常生活需求尚远.之所以在部分封闭场 景下行为智能能实现,原因即在于此时对应的相关 概念可以保证其三指等价.

粗略地说,感知智能是人工智能中的基础智能, 可视为人工智能的 1.0 阶段.认知智能是人工智能的 2.0 阶段.情感智能则为人工智能的 3.0 阶段.行为智能 可以看作是人工智能的 4.0 阶段.目前的人工智能发 展已经进入了 AI2.0 时代,未来的 AI3.0 和 4.0 还有 待努力.

5 ChatGPT 的影响

人工智能发展至今,迈入认知智能时代,确实 取得了重大进步.虽然离 AI3.0 和 4.0 距离尚远,但依 然将对我们的生活产生重要影响:

1)生成式 AI 的成功提醒我们,符号世界、心 理世界、物理世界三界同构假设不是恒真.今后,各 种符号的证据力量需要检测,不能预设为真. 这不仅 大幅提升认知成本,还考验认知能力.随着类似 ChatGPT 工具的普及,它可能代表认知的最低水准.

2)每次技术进步,都对教育提出了更高的要求, 这次也不例外. ChatGPT 展现出的认知水平要求人们 更注重提出问题和独立判断的能力.鉴于符号世界的 人类普适性,教育尤其是高等教育需要提前布局.

3)ChatGPT 表明认知智能已可用,但依然不可 能通过原始的图灵测试.这表明图灵测试是有启发性 的思想实验,但不是衡量智能的实践标准.

4)ChatGPT 的成功为国内人工智能学术界同时 带来机遇与挑战.机遇包括提高学界对相关问题的理 解,例如任务的主观性,以往的多任务可能在新视 角下视为单任务;同时,全社会对人工智能潜在能 力的直观体验和认可得到提升,将极大推动相关产 业的发展.然而,挑战也不容忽视:应用研究方面, 社会对技术的期待值提高,实效性和实用性至关重 要;理论研究方面,技术已领先于理论,亟需加强 理论研究.

5)类 ChatGPT 技术的大规模应用可能导致意识 形态等方面的信息茧房效应. 特别是类 ChatGPT 是中 心化的 AI 平台,容易使人们在获取信息时只接触到 特定内容和片面观点,这一方面会加剧社会分化, 另一方面会降低观点多样性,阻碍创新思维的产生, 为社会带来潜在危害.

6)大模型对计算量的巨大需求可能会加剧全球 能源危机,并对环境产生不良影响.我们期望 AI for science 通过加速科学发现,更迅速地找到可持续能 源解决方案和新的节能技术,从而尽量降低这些负 面影响.

7)ChatGPT 在提高生产力方面潜力巨大.通过自 动化处理一些繁琐的、重复性的任务,它可以解放 人们的时间和精力,让人们关注于更有价值、更具 创造力的工作,进一步推动社会创新和发展.

参 考 文 献

[1] Raffel C, Shazeer N, Roberts A, et al. Exploring the limits of transferlearning with a unified text-to-text transformer[J]. The Journal of Machine Learning Research. 2020, 21(1):5485-5551

[2] Zhou Y, Muresanu AI, Han Z, et al. Large language models are human-level prompt engineers[OL]. arXiv preprint arXiv:2211.01910. 2022

[3] Wei J, Tay Y, Bommasani R, et al. Emergent abilities of large language models[OL]. arXiv preprint arXiv:2206.07682. 2022

[4] Polanyi M, Sen A. The tacit dimension[M]. Chicago, IL: University of Chicago Press,2009

[5] Wu C, Yin S, Qi W, et al. Visual chatgpt: Talking, drawing and editing with visual foundation models[OL]. arXiv preprint, arXiv:2303.04671. 2023

[6] Yang Z, Li L, Wang J, et al. MM-REACT: Prompting ChatGPT for Multimodal Reasoning and Action[OL]. arXiv preprint, arXiv:2303.11381. 2023

[7] Shen Y, Song K, Tan X, et al. HuggingGPT: Solving AI Tasks with ChatGPT and its Friends in HuggingFace[OL]. arXiv preprint, arXiv:2303.17580, 2023

[8] Borji A. A categorical archive of chatgpt failures[OL]. arXiv preprint, arXiv:2302.03494. 2023

[9] Liu Y, Liu X, Chen H, et al. Does Debiasing Inevitably Degrade the Model Performance[OL]. arXiv preprint, arXiv:2211.07350. 2022

[10] Zhuo TY, Huang Y, Chen C, et al. Exploring ai ethics of chatgpt: A diagnostic analysis[OL]. arXiv preprint, arXiv:2301.12867. 2023

[11] Carlini N, Tramer F, Wallace E, et al. Extracting Training Data from Large Language Models[C] //Proc of USENIX Security Symp. Berkeley, CA : USENIX Association, 2021: 2633-2650

[12] Luft J, Ingham H. The Johari window, a graphic model of interpersonal awareness[C] //Proc of the Western Training Laboratory in Group Development. Los Angeles: University of California, Los Angeles, 1955, 246

[13] Gao L, Madaan A, Zhou S, et al. PAL: Program-aided Language Models[OL]. arXiv preprint, arXiv:2211.10435. 2022

[14] Yao Shunyu, Zhao J, Yu Dian, et al. ReAct: Synergizing reasoning and acting in language models [C] //Proc of the Int Conf on Learning Representations (ICLR). 2023[2023-04-10]. https://arxiv.org/abs/2210.03629

[15] Shinn N, Labash B, Gopinath A. Reflexion: An autonomous agent with dynamic memory and self-reflection[OL]. arXiv preprint, arXiv:2303.11366. 2023

[16] Ross W D. Aristotle on His Predecessors, Being the First Book of His Metaphysics [M] (1908): 110-113

[17] Tarski A. The semantic conception of truth: and the foundations of semantics[J]. Philosophy and Phenomenological Research. 1944,4(3):341- 376

[18] Yu Jian. Brilliance and Darkness: Turing Test[J]. Journal of Computer Research and Development, 2020, 57(5): 906-911(in Chinese) (于剑. 图灵测试的明与暗[J],计算机研究与发展,2020,57(5):906-911)

[19] Russell B. An Inquiry into Meaning and Truth [M].Beijing: China Commerce and Trade Press,2012 (罗素. 意义与真理的探究[M]. 北京:商务出版社,2012)

[20] Xiao G, Lin J, Han S. Offsite-Tuning: Transfer Learning without Full Model[OL]. arXiv preprint, arXiv:2302.04870. 2023

[21] Held R, Hein A. Movement-produced stimulation in the development of visually guided behavior [J]. Journal of Comparative and Physiological Psychology, 1963, 56(5):872

[22] Vemprala S, Bonatti R, Bucker A, et al. Chatgpt for robotics: Design principles and model abilities.2023

[23] Bai Y, Kadavath S, Kundu S, et al. Constitutional AI: Harmlessness from AI Feedback[OL]. arXiv preprint, arXiv:2212.08073. 2022

专知便捷查看

便捷下载,请关注专知公众号(点击上方蓝色专知关注)

后台回复或发消息“CGTC” 就可以获取《从ChatGPT看AI未来趋势和挑战 | 万字长文》专知下载链接

专知,专业可信的人工智能知识分发,让认知协作更快更好!欢迎注册登录专知www.zhuanzhi.ai,获取100000+AI(AI与军事、医药、公安等)主题干货知识资料!

点击“阅读原文”,了解使用专知,查看获取100000+AI主题知识资料

原文链接:https://blog.csdn.net/cf2SudS8x8F0v/article/details/130234067?ops_request_misc=%257B%2522request%255Fid%2522%253A%2522170018760116800180639886%2522%252C%2522scm%2522%253A%252220140713.130102334.pc%255Fblog.%2522%257D&request_id=170018760116800180639886&biz_id=0&utm_medium=distribute.pc_search_result.none-task-blog-2~blog~first_rank_ecpm_v1~times_rank-8-130234067-null-null.nonecase&utm_term=AI%E6%B3%95%E5%BE%8B%E5%92%A8%E8%AF%A2